1、使用MNIST数据集实验,可视化特征的输出。下图是使用softmax损失函数训练的结果。特征具有可分性。

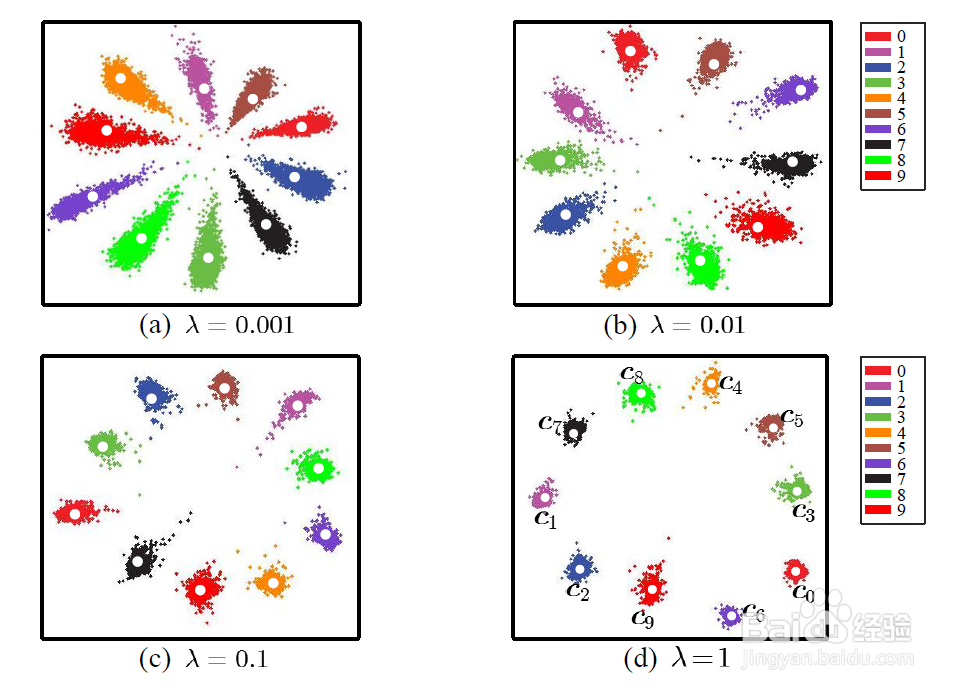

2、使用center loss +softmax loss联合训练。除了特征的可分之外,能够有效提升特征的辨识度。

3、中心损失的目的是增大类间距离,降低类内方差。类似于k-means聚类的定义方式。

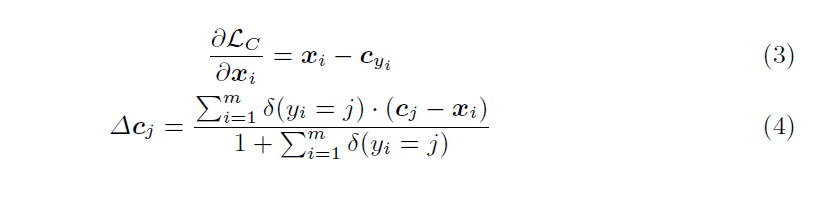

4、中心损失的梯度表示如下。同时还需要更新类中心的位置。

5、损失函数是softmax loss与center loss的联用。表示如下

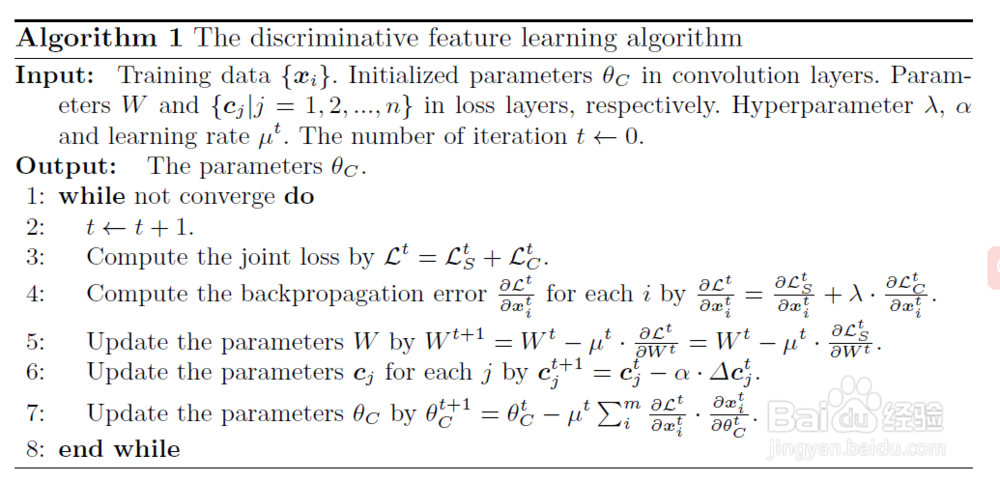

6、可分辨特征的学习算法如下表示。整个网络结构如下图所示。